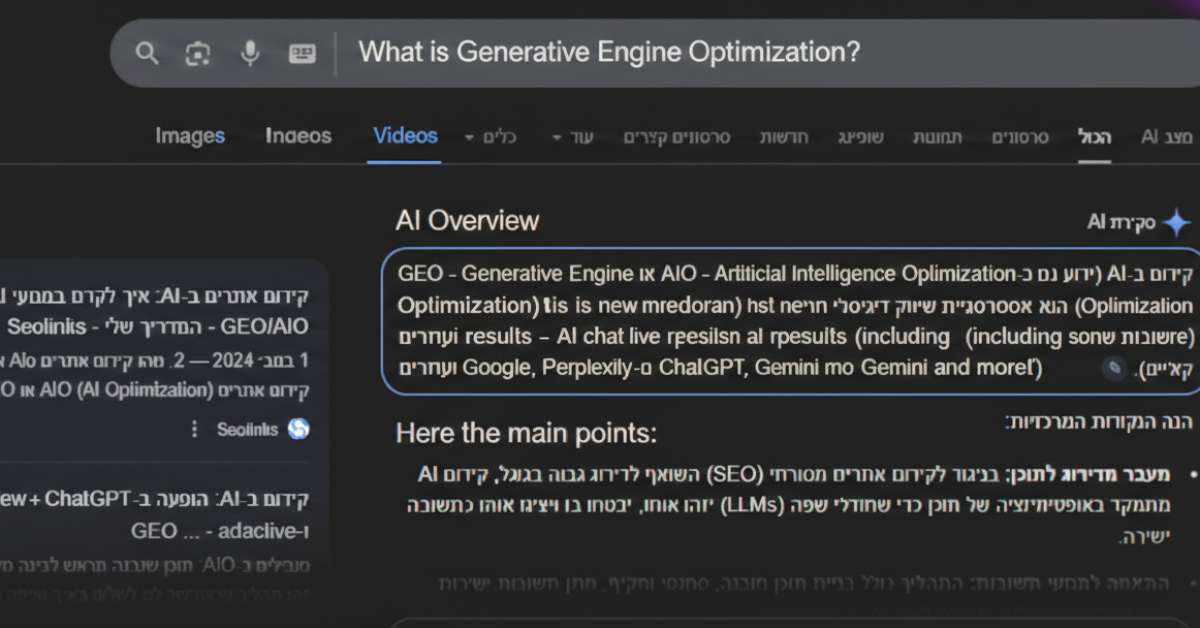

בעידן הבינה המלאכותית הגנרטיבית, קידום אתרים עובר מ-SEO (Search Engine Optimization) ל-GEO (Generative Engine Optimization). המטרה היא להפוך את תוכן האתר למקור המידע המהימן והנגיש ביותר עבור מודלי שפה גדולים (LLMs). מאמר זה מפרט את חמשת עמודי התווך לבניית אתר ש"רובוטים" של AI יעדיפו לצטט: מבנה נתונים מובנה, סמכותיות נושאית (Topic Authority), שפה טבעית מבוססת ישויות, אופטימיזציה טכנית לסריקת בוטים, ושימוש ב-E-E-A-T.

התשתית הטכנית: שפת המכונה (JSON-LD ו-Schema)

זהו החלק הקריטי ביותר עבור ה"רובוטים". נתונים מובנים הם הדרך שבה אתה אומר ל-AI בדיוק מה הוא רואה, בלי להשאיר מקום לפרשנות.

Schema Markup מתקדם

אל תסתפק ב-Schema בסיסי של "Article". השתמש בסימון ספציפי:

-

FAQPage: מאפשר ל-AI לשלוף שאלות ותשובות ישירות לצ'אט.

-

Product & Offer: מאפשר השוואת מחירים ותכונות בזמן אמת.

-

Person & Organization: עוזר ל-AI לבנות את ה-E-E-A-T שלך (ניסיון, מומחיות, סמכותיות ואמינות).

הטמעת JSON-LD

הקוד צריך להיות נקי, תקני ומוטמע ב-<head> של האתר.

דוגמה למבנה יעיל:

JSON{ "@context": "https://schema.org", "@type": "TechArticle", "headline": "איך לבנות אתר מותאם AI", "author": {"@type": "Person", "name": "מומחה AI"}, "mainEntityOfPage": "https://www.example.com/ai-optimization" }

אסטרטגיית תוכן: שיטת ה-Direct-to-Answer

מודלי AI מנסים לחסוך למשתמש זמן. אם המאמר שלך מתחיל בסיפורים ארוכים ("מאז ומעולם בני האדם חיפשו מידע…"), ה-AI יתקשה למצוא את העיקר.

מודל הפירמידה ההפוכה

-

התשובה הישירה: הפסקה הראשונה (עד 50 מילים) חייבת לענות על השאלה המרכזית.

-

נתונים תומכים: טבלאות, רשימות (Bullet points) וסטטיסטיקות.

-

פירוט והרחבה: רק לאחר מכן מגיע הרקע ההיסטורי או ההסבר המעמיק.

כותרות כשאילתות

השתמש בתגיות H1, H2, H3 כאל שאלות שהמשתמש עשוי לשאול את ה-AI.

-

במקום כותרת כמו "היתרונות שלנו", השתמש ב"מהם היתרונות של שימוש במערכת ה-AI שלנו לעסקים?".

סמכותיות ואמינות (E-E-A-T בתקופת ה-AI)

מודלי AI עוברים אימון על בסיס "מקורות מהימנים". כדי שהאתר שלך ייחשב כזה:

-

ביוגרפיות מחברים (Author Authority): לכל מאמר חייב להיות דף מחבר עם קישורים ל-LinkedIn, פרסומים קודמים ותעודות מקצועיות.

-

הערות שוליים וסימוכין: קישור למחקרים חיצוניים, דוחות ממשלתיים או אתרי חדשות גדולים. ה-AI סורק את הקישורים האלו כדי לאמת את העובדות שכתבת.

-

דיוק עובדתי: טעות אחת גסה בנתונים עלולה לגרום ל-AI "לסמן" את האתר שלך כבלתי אמין (Hallucination trigger).

נגישות לבוטים (Crawlability & Performance)

אם הבוט של OpenAI (GPTBot) או Google (Google-InspectionTool) לא יכולים לגשת לדף במהירות, המידע שלך לא יופיע בתשובות.

קובץ Robots.txt עדכני

ודא שאתה לא חוסם בטעות את הבוטים החדשים של ה-AI.

Plaintext

User-agent: GPTBot

Allow: /

User-agent: Google-InspectionTool

Allow: /

מהירות וקוד נקי

-

מינימיזציה של JS/CSS: בוטים מעדיפים לקרוא HTML טהור. עודף סקריפטים מקשה על ה-AI "לגרד" (Scrape) את התוכן.

-

Core Web Vitals: מהירות היא עדיין פקטור. אתר מהיר נסרק בתדירות גבוהה יותר.

כדי לבנות את האתר הטוב ביותר עבור AI בשנת 2026, עליך להפסיק לחשוב על "דירוג בגוגל" ולהתחיל לחשוב על "מתן ערך למודל שפה". אתר שמגיש את המידע בכפית של כסף (דרך Schema), מציג תשובה ברורה כבר בשנייה הראשונה ומגבה אותה בנתונים ובסמכותיות, הוא זה שייבחר להיות ה"מקור" בשיחות של מיליוני משתמשים עם הבינה המלאכותית שלהם.